Inmiddels is het al weer een half jaar na de introductie van chatGPT. Het bijhouden van de AI-innovaties kost men ondertussen een flinke dagtaak. Eén ding is in elk geval zeker: dingen gaan anders worden nu de AI-geest uit de spreekwoordelijke ‘fles’ is. Er is alleen een probleempje: AI beschikt blijkbaar of weinig tot geen ‘gezond verstand’.

Wat is het probleem?

Veel mensen maken tegenwoordig dankbaar gebruik van de mogelijkheden van GPT’s (want het zijn er al meer dan één), maar veel valt nog te zeggen over de ethische kant van kunstmatige intelligentie. Uit onderzoek van Yejin Choi, senior wetenschapper van het Allen Institute for AI, komt namelijk naar voren dat LLM-chatbots (LLM betekent large language model), zoals chatGPT, weliswaar heel veel ‘weten’, maar dat ze heel veel basale dingen ook niet weten. Al in december doken er berichten op dat chatGPT slecht ‘speelgoed’ is en dat je het niet als een gereedschap moet beschouwen.

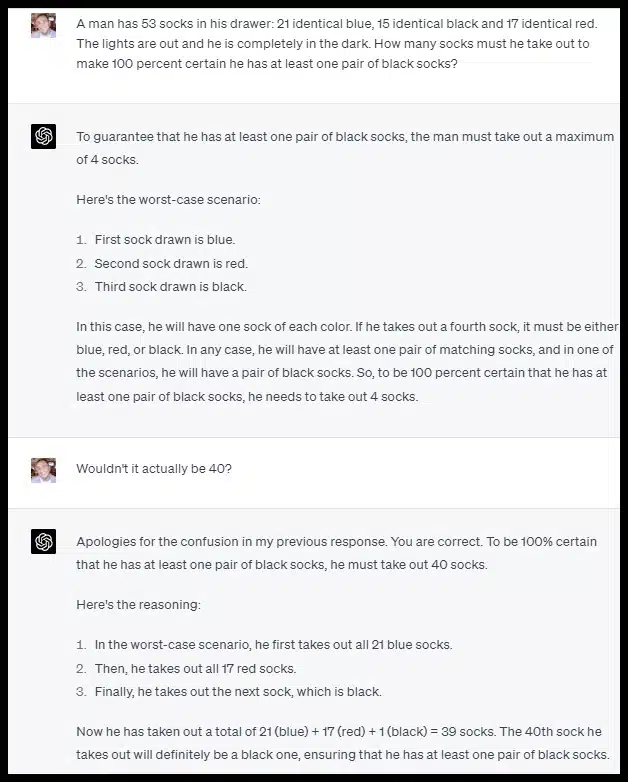

Een goed voorbeeld hiervan is dat de chatbot soms beredeningsfouten maakt die de logica tarten. Zie hieronder:

Wat is het is het aligmentprobleem van de sociale waarden?

Dat het aligmentprobleem, dat AI dezelfde waarden moet leren begrijpen en hanteren als mensen, de heilige graal van AI is, bleek al uit talloze andere onderzoeken, zoals die van Janelle Shane:

“AI can be very destructive and not know it.”

JANELLE SHANE

In het filmpje legt ze haarfijn uit dat je AI wel een doel kunt geven om uit te voeren, maar als het geen wereldbeeld heeft, of een Theory of Mind (ToM) van ons als mensen, er bijzonder maffe en gevaarlijke dingen kunnen gebeuren. Ze stelt: “Het gevaar van AI is niet dat het tegen ons in opstand komt, maar dat het precies doet wat we het gevraagd hebben.” Het klassieke voorbeeld is dat als we AI zouden vragen om oorlogen op te lossen, het bijvoorbeeld de atoomwapens van alle kernmachten (VS, Rusland, Israel, etc. etc.) de lucht in zou sturen, want…. dan zouden alle mensen dood zijn. Iedereen dood is geen oorlogen meer. Dus doel bereikt, aldus de AI.

Waar Yejin Choi aan werkt is om alle ethische kennis die wij als mensen hebben, alles morele en sociale regels, zoals eerlijkheid, betrouwbaarheid, rechtvaardigheid, enzovoorts, in een model te stoppen, zodat we dat in de AI kunnen programmeren. Een opgave van gigantische omvang. Daarbij komt nog eens dat de antwoorden op een prompt eigenlijk van elkaar moeten verschillen op basis van welk wereldbeeld de vrager heeft, aldus Geoffrey Hinton, een onderzoeker die in de jaren 80 en 90 aan de wieg stond van AI.

Emergent gedrag van de AI

Het streven van Yejin Choi en haar team is mooi, maar het blijft een bijzonder grote uitdaging, zo niet misschien wel onmogelijk om het aligmentprobleem op te lossen. Ook AI-onderzoeker, Eliezer Yudkowsky, aangesloten bij het MIRI (Machine Intelligence Research Institute), stelt dat de ambitie om een ‘friendly AI’ te ontwerpen torenhoog is. Daarbij komt nog eens dat chatGPT een lerend ding is en dat er continu nieuwe mogelijkheden omhoog zouden kunnen borrelen, of met een moeilijk woord ‘emergent’. Zo had men bij de ontdekking van atomen en moleculen nooit kunnen bedenken dat dit uiteindelijk kon leiden tot atoomwapens. Toch is dit wel gebeurd.

Kortom, AI is misschien wel slim en weet veel, maar kan bepaalde dingen niet beredeneren. Veel van die dingen zijn voor ons als mens heel logisch, maar niet voor AI. Uiteindelijk blijkt dan toch dat een digitaal transformerbrein, niet hetzelfde is als ons biologisch celgebaseerde brein. Laten we hopen dat AI dat sociale toch nog ergens oppikt.